09 июня 2016. Роб Дэвис

Перевод блога Mellanox

Сегодня организация NVM Express опубликовала 1 версию стандарта NVM Express over Fabrics (NVMf). Усилия по его разработке были запущены 3го сентября 2014 и благодаря стараниям большого числа компаний, включая Mellanox, были завершены. Хотя стандарт и был опубликован только сегодня, мы осуществляли испытания концепции и выполняли демонстрацию NFMf совместно с рядом партнёров и первичных потребителей адаптеров на протяжении более года.

NVMf делает возможным для нового высокопроизводительного интерфейса SSD, NVMe (Non-Volatile Memory Express) осуществлять соединения в сетевых средах, допускающих RDMA. Это первая построенная с нуля технология сетевого хранения, которая будет развиваться на протяжении 20 лет. Соединяясь с новыми скоростями Ethernet и InfiniBand которые теперь превысили 100Гб/с, NVMf не просто будет впечатляюще улучшать производительность существующих приложений сетевого хранения, но также ускорит приспособление новых и грядущих технологий, подобных горизонтальному масштабированию, определяемых ПО хранилищ, гиперконвергентных инфраструктур и рассредоточение вычислений/ хранения.

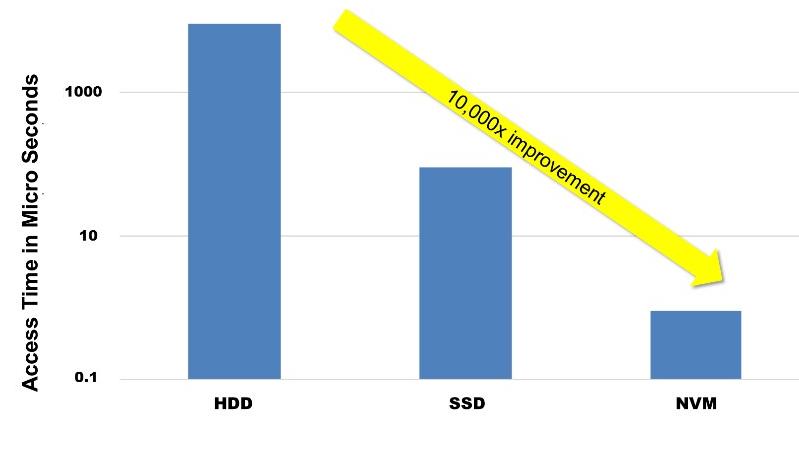

Производительность технологий хранения возросла в сотни раз за последние пять лет, поскольку на рынок пришли твердотельные диски (SSD) на основе флеш- памяти и, в особенности, SSD соединяющиеся через NVMe.

Технологии носителей хранения®

Рисунок 1. Более новые хранилища экспоненциально быстрее более старых

Новые технологии Non-Volatile Memory (NVM) и Persistent Memory (PM) не за горами, что вновь даст прирост производительности в сотни раз по отношению к SSD сегодняшнего дня. Без более высокоскоростных технологий сетей и протоколов, подобных NVMf, такие новые технологии SSD и NVM окажутся запертыми внутри вашего сервера.

®

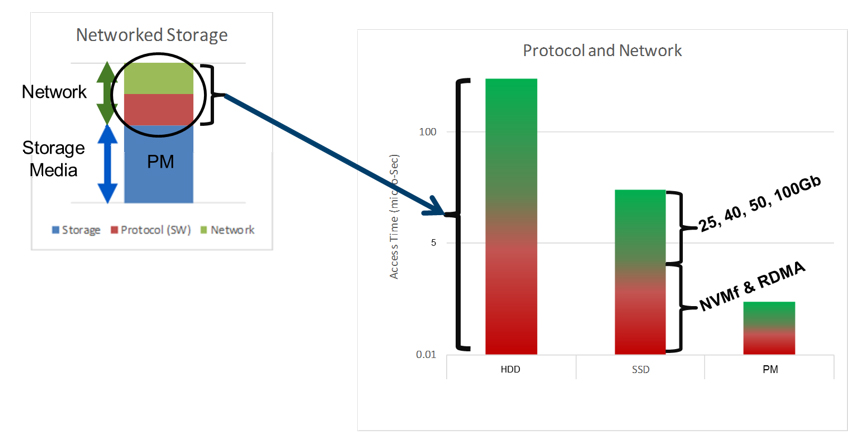

Рисунок 2. По мере уменьшения латентности хранения становятся относительно более важными латентности протоколов и сетевых сред, и они подлежат уменьшению

Так как производительность хранилищ растёт, сетевые кабели и протоколы становятся бутылочным горлышком. Мы можем ускорить кабельные соединения последними скоростями Ethernet и InfiniBand, однако также необходимы новые, более эффективные протоколы. К счастью, NVMf может быть усилен RDMA (Remote Direct Memory Access), который позволяет возвысить NVMf в сетевой среде.

®

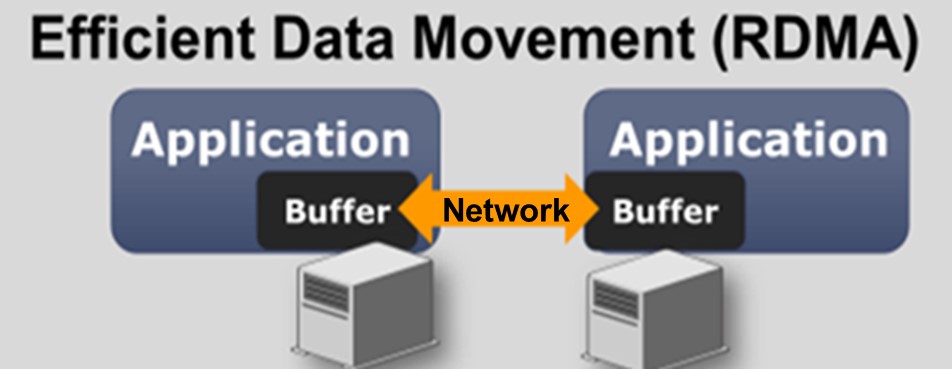

Рисунок 3. RDMA делает возможным прямой обмен данными с отсутствием копирования, причём с аппаратным ускорением, между ОЗУ серверов, уменьшая сетевую латентность и разгружая ЦПУ этих систем.

RDMA over InfiniBand и RoCE (RDMA over Converged Ethernet) делают возможным обмен данными по сети между устройствами компьютеров и хранилищ из оперативной памяти с минимальным применением ЦПУ или даже без них. Это осуществляется при помощи аппаратной разгрузки обмена в сетевых адаптерах, которые поддерживают RDMA.

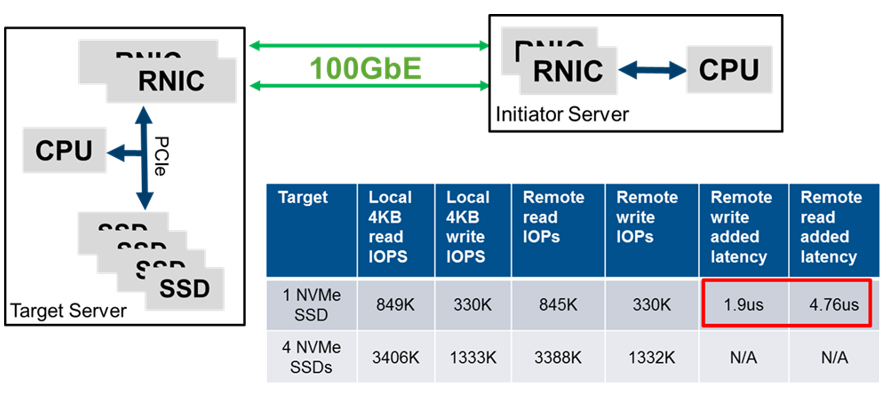

Естественно, производительность зависит от большого числа различных факторов, самих SSD, архитектур инициатора (Сервера) и Получателя (Target, устройство хранения), а также, конечно, самой сетевой среды. Вот результаты одного нашего теста при содействии партнёра для конференции в прошлом году:

®

Рисунок 4. Предваряющая стандарт демонстрация NVMf с сетевой средой 100GbE Mellanox показывает очень низкую латентность коммутации в сравнении с применением тех же самых NVMe локально.

Наиболее интересными данными являются добавленные значения латентности. Это разницы в латентности между SSD тестируемыми локально в сервере получателя в сопоставлении с удалённым тестированием по нашей сети с NVMf. Следует отметить, что это была ранняя версия до введения стандарта и применялись высоко оптимизированные системы инициатора и получателя, тесно интегрирующие с SSD, при дуальном 100GbE соединении с использованием адаптеров Ethernet Mellanox ConnectX-4. Однако даже удвоение или утроение этих значений демонстрирует впечатляющую производительность недостижимую при современных технологиях сетевого хранения.

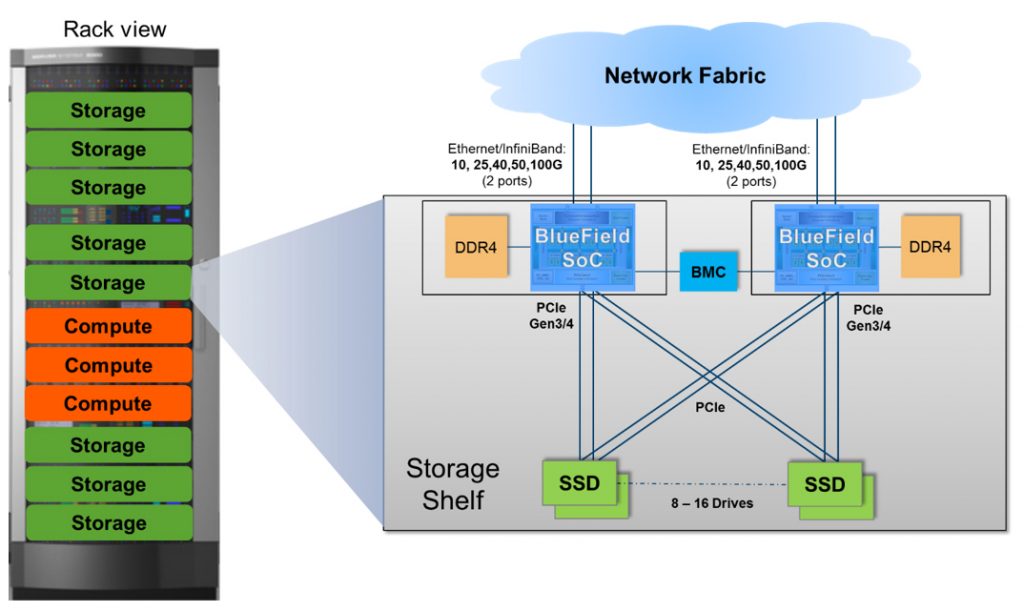

Этот новый стандарт вдвойне интересен для меня, поскольку Mellanox является безусловным лидером в обеих высокоскоростных средас с RDMA. Мы владеем более чем 90 процентами рынка как для адаптеров 40GbE, так и для InfiniBand и мы были первыми на рынке с адаптерами и коммутаторами 25/50/100Гб/с Ethernet. Высокая производительность сетевых решений Mellanox помогает более быстрым NVMe SSD и более эффективным NVMf протоколам воссиять. Кроме этого, Mellanox только что анонсировал BlueField, систему с большим числом ядер на микросхемах, которые идеальны для управления и соединения полок NVMf.

®

Рисунок 5. BlueField Mellanox включает в себя высокоскоростую сетевую среду, разгрузку RDMA, множество ядер ЦПУ, большое число каналов (lane) PCIe, а также DRAM, делая его идеальным контроллером NVMe over Fabric.

Мне весьма повезло, или я достаточно стар, быть вовлечённым и работать над версией спецификации 1.0 Fibre Channel в 1994. Поэтому я не выдумываю, когда говорю: "Это первая новая построенная с нуля сетевая технология хранения данных на ближайшие 20 лет." Уровень возбуждения и интереса в компьютерной индустрии на более высоком уровне чем это было тогда. NVMf является идеальной технологией для заполнения недавно возникшей зияющей дыры между производительностью систем хранения и производительностью сети хранения данных. У нас в Mellanox имеется набор продуктов для заполнения этой пропасти, который мы разрабатывали и тестировали совместно с партнёрами на протяжении последних нескольких лет.

-

NVMe Over Fabrics: Open Source Linux Drivers

-

Mellanox Ethernet NICs: ConnectX-4 EN and ConnectX-4 Lx EN

-

PMC Sierra (now Microsemi) Demonstrating NVMe over Fabrics Blog