Частичный перевод Mellanox OFED for Linux User Manual, Rev. 3.20 и связанных материалов.

- Понимание разгрузки удаляющего кодирования

- Стек протоколов Mellanox OFED

- Введение

- Установка{-}

- Обзор функциональности и настройка{~}

- Утилиты системы коммуникации InfiniBand{-}

- Обнаружение неисправностей{-}

- Стек протоколов Intel®

Mellanox OFED является единым программным стеком Virtual Protocol Interconnect (VPI), который работает на всех решениях сетевых адаптеров Mellanox для поддержания следующих восходящих связей с серверами:

| Восходящая связь/ HCA | Скорость восходящей линии |

|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 56 GbE является внутренним стандартом Mellanox и может быть получен при использовании плат адаптеров Mellanox соединяемых коммутаторами серий Mellanox SX10XX или соединением плат адаптеров Mellanox друг с другом. |

|

Все платы сетевых адаптеров Mellanox совместимы с протоколами на основе OpenFabrics RDMA и программного обеспечения, которое поддерживается основными дистрибутивами операционных систем.

Mellanox OFED сертифицирован со следующими продуктами:

-

Программное обеспечение Mellanox Messaging Accelerator (VMA®): Библиотека ускорения сокетов которая выполняет проброс операционной системы для приложений на основе стандартных сокетов.

Заметьте, пожалуйста, что поддержка VMA осуществляется отдельно от поддержки Mellanox OFED. За дополнительной информацией, пожалуйста, пользуйтесь документацией по VMA, расположенной на: www.mellanox.com > Accelerator Software > VMA

-

Программное обеспечение Mellanox Unified Fabric Manager (UFM®): Мощная платформа для управления масштабирования по запросу вычислительной сетевой среды окружения, построенный поверх механизма маршрутизации промышленного стандарта OpenSM.

-

Fabric Collective Accelerator (FCA) - FCA является пакетом программного обеспечения Mellanox объединяемого при помощи MPI, который применяет технологию CORE-Direct для реализации коллективного взаимодействия на уровне MPI.

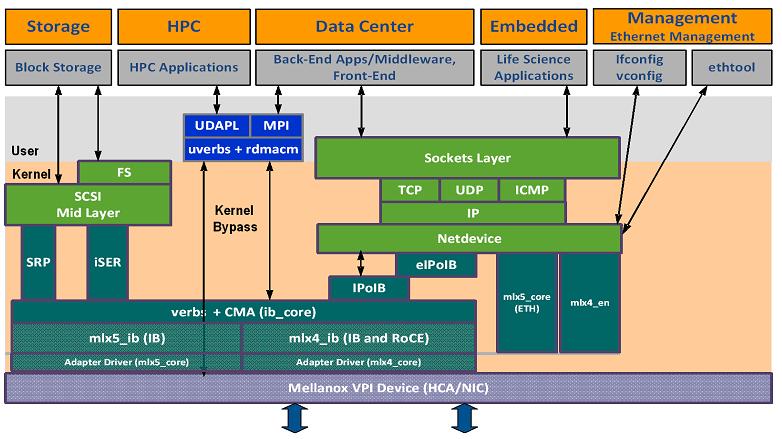

Рисунок 1 отображает стек Mellanox OFED и то, как протоколы верхнего уровня (ULP) взаимодейтсвуют с аппаратными средствами, а также с пространствами ядра и пользователя. Прикладной уровень также показывает универсальность рынков, к которым применим Mellanox OFED.

Последующие подразделы вкратце описывают различные компоненты стека Mellanox OFED.

Драйвер mlx4 VPI

mlx4 является реализацией драйвера нижнего уровня для семейства адаптеров ConnectX®,

разработанных Mellanox Technologies. ConnectX®2 и ConnectX®3 могут работать как адаптеры InfiniBand или как

NIC Ethernet. Драйвер OFED поддерживает конфигурации InfiniBand и Ethernet. Для обеспечения конфигураций данный драйвер разветвляется на

следующие модули:

mlx4_core

Обрабатывает функции нижнего уровня, такие как инициализация устройства и выполнение команд встроенного ПО. Также управляет выделением ресурсов таким образом, что InfiniBand и Ethernet могут совместно использовать одно устройство без взаимодействия друг с лругом.

mlx4_ib

Обрабатывает специфичные для InfiniBand функции и встроен в средний уровень InfiniBand

mlx4_en

Драйвер 10/40GigE под drivers/net/ethernet/mellanox/mlx4, который обрабатывает специфичные для Ethernet функции и подключается к среднему уровню netdev

Драйвер mlx5

mlx5 является реализацией драйвера нижнего уровня для семейства адаптеров Connect-IB®

и ConnectX®-4, разработанных Mellanox Technologies. Connect-IB® работает как адаптер InfiniBand, в то время как

и ConnectX®-4 работает как адаптер VPI (InfiniBand и Ethernet). Драйвер mlx5

включает в себя следующие модули ядра:

mlx5_core

Действует как библиотека общих функций (т.е. инициализирует устройство после его сброса) необходимых платам адаптера Connect-IB®

и ConnectX®-4. Драйвер mlx5_core также реализует интерфейсы Ethernet для

ConnectX®-4. В отличие от mlx4_en/core, драйверам mlx5

не требуется модуль mlx4_en, поскольку функциональность Ethernet встроена в сам модуль

mlx5_core.

mlx5_ib

Обрабатывает специфичные для InfiniBand функции и встроен в средний уровень InfiniBand

libmlx5

libmlx5 является поставщиком библиотеки, которая реализует аппаратную функциональность специфичную

для пространства пользователя. Если

отсутствует совместимость между встроенным ПО и данным драйвером, драйвер не загрузится и в dmesg будет выведено некое сообщение.

Далее приводятся переменные окружения libmlx5:

-

MLX5_FREEZE_ON_ERROR_CQE:-

В случае завершения с ошибкой вызывает обработку данного процесса в цикле, что не возбуждает ошибку или возникновения переполнения повторов

-

В противном случае запрещён

-

-

MLX5_POST_SEND_PREFER_BF:-

Настраивает каждый рабочий запрос, который может использовать голубую вспышку применять её

-

В противном случае - голубая вспышка зависит от размера конкретного сообщения и индикации данного пакета в потоке

-

MLX5_SHUT_UP_BF:

-

Запрещает функцию голубой вспышки

-

В противном случае не запрещает

MLX5_SINGLE_THREADED:

-

Любые циклы с ожиданием ресурса (spinlock) запрещены

-

В противном случае spinlock разрешены

-

Применяется приложениями, которые являются однопоточными и хотят сберечь накладные расходы получая циклы ожидания ресурсов.

MLX5_CQE_SIZE:

-

64 - размер записи очереди выполнения (CQE, completion queue entry) установлен в 64 байта (по умолчанию)

-

128 - размер записи очереди выполнения установлен в 128 байта

MLX5_SCATTER_TO_CQE:

-

Небольшие буферы рассеиваются по записи очереди выполнения и обрабатываются данным драйвером. Имеет силу для транспорта с гарантированным соединением (RC, Reliable Connected).

-

Значение по умолчанию 1, в противном случае запрещено

MLX5_ENABLE_CQE_COMPRESSION:

-

Сберегает пропускную способность PCIe сжимая несколько CQE в меньшее количество байт в PCIe. Установка в значение 1 делает возможным сжатие CQE.

-

Значение по умолчанию 0 (запрещёно)

Ядро среднего уровня

Службы центральной части (core) включают: интерфейс управления (MAD), интерфейс менеджера соединений (CM), а также интерфейс администратора подсети (SA). Стек включает компоненты приложений как для режима пользователя, так и ядра. Службы центральной части выполняются в ядре (kernel) и представляют интерфейс режиму пользователя для редактирования, CM и управления.

Протоколы верхнего уровня (ULP)

IP поверх IB (IPoIB)

Драйвер IP поверх IB (IPoIB) является реализацией сетевого интерфейса над InfiniBand. IPoIB инкапсулирует сетевые дейтаграммы в соединения InfiniBand или в службу транспорта дейтаграмм. IPoIB предваряет дейтаграмму IP инкапсулирующим заголовком и отправляет сквозь имеющуюся службу транспорта Infiniband. По умолчанию службой транспорта является ненадёжная доставка (UD, Unreliable Datagram), однако она может быть настроена на надёжную доставку (RC, Reliable Connected). Данный интерфейс поддерживает индивидуальную (unicast), групповую (multicast) и широковещательную (broadcast) передачи. Подробнее в разделе 3.5.2.1, "IP over IB (IPoIB)".

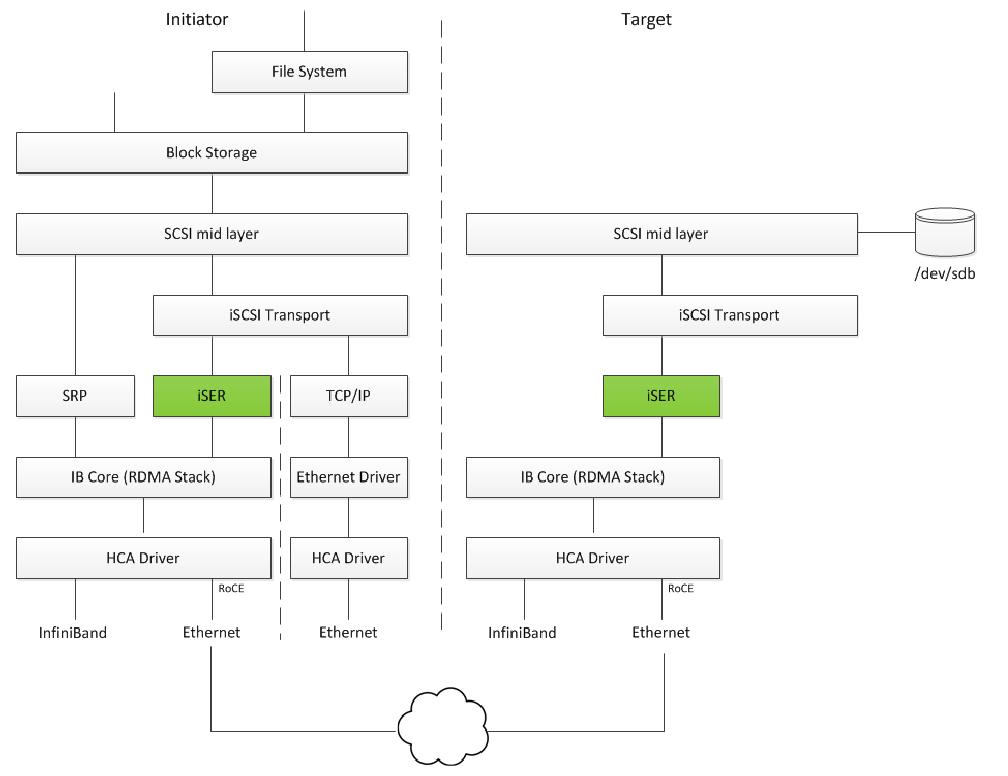

Расширения iSCSI для RDMA (iSER)

Расширения iSCSI для RDMA (iSER) распространяют протокол ISCSI на RDMA. Это делает возможной пересылку данных напрямую в буферы SCSI и из них без промежуточного копирования данных. Для дополнительных подробностей смотрите раздел 3.3.3, "Расширения iSCSI для RDMA (iSER)".

Sockets Direct Protocol (SDP)

Протокол непосредственных сокетов (SDP, Sockets Direct Protocol) является транспортным протоколом потоков байт, который предоставляет семантику потоков TCP. SDP использует возможности разгрузки современного протокола InfiniBand. Благодаря этому SDP может потреблять меньше ресурсов пропускной способности ЦПУ и оперативной памяти в сравнении с обычными реализациями TCP при сохранении API и семантики TCP, которые необходимы большинству современных сетевых приложений. Для дополнительных подробностей смотрите раздел 3.3.2, "Sockets Direct Protocol (SDP)".

SCSI RDMA Protocol (SRP)

SCSI RDMA Protocol (SRP) разработан для получения всех преимуществ разгрузки данного протокола и функциональности RDMA предоставляемой архитектурой InfiniBand. Драйвер SRP - называемый инициатором (Initiator) SRP - отличается от обычных драйверов нижнего уровня SCSI в Linux. Инициатор (Initiator) SCSI не управляет локальным HBA; вместо этого он управляет соединением с контроллером ввода/ вывода - называемого получателем (Target) SCSI - для предоставления доступа к удалённым устройствам хранения поверх среды коммутации InfiniBand. Получатель (Target) SRP располагается в устройстве ввода/ вывода и предоставляет службы хранения. Для дополнительных подробностей смотрите раздел 3.3.1, "SCSI RDMA Protocol (SRP)".

User Direct Access Programming Library (uDAPL)

Библиотека программирования непосредственного доступа пользователя (uDAPL, User Direct Access Programming Library) является стандартным API, который предлагает приложениям центра обработки данных производительность, масштабируемость и надёжность обмена сообщениями данных поверх интерконнекта RDMA: InfiniBand и RoCE. Интерфейс uDAPL определяется сообществом DAT.

Данная редакция пакета эталонной реализации uDAPL для обеих спецификаций DAT, и для 1.2, и для 2.0 приурочена к выпуску программного стека OFED для открытой среды коммутации (Open Fabrics www.openfabrics.org). За дополнительной информацией о сообществе DAT обратитесь к его сайту: http://www.datcollaborative.org.

MPI

Интерфейс обмена сообщениями (MPI, Message Passing Interface) является спецификацией библиотеки, которая делает возможной разработку библиотек параллельно выполняемого программного обеспечения для применения параллельных компьютеров, кластеров и разнородных сред. Mellanox OFED включает в себя следующие реализации MPI поверх InfiniBand:

-

Open MPI – реализацию MPI-2 с открытым исходным кодом в рамках проекта Open MPI

-

OSU MVAPICH – реализацию MPI-1 государственного университета Огайо (Ohio State University)

Также Mellanox OFED включает в себя эталонные тесты MPI, такие как OSU BW/LAT, Intel MPI Benchmark и Presta.

InfiniBand Subnet Manager

Всем протоколам верхнего уровня (ULP) совместимым с InfiniBand необходим соответствующим образом работающий менеджер подсети (SM, Subnet Manager), выполняющийся в среде коммутации InfiniBand, причём постоянно. SM может выполняться на любом узле или в коммутаторе IB. OpenSM является InfiniBand- совместимым менеджером подсети и поставляется как часть Mellanox OFED (По умолчанию OpenSM отключён. Подробности его подключения в раздел 3.2.2, "OpenSM").

Утилиты диагностики

Mellanox OFED включает в себя два следующих диагностических пакета для применения менеджерами сети и центров обработки данных:

-

ibutils – диагностические утилиты Mellanox Technologies

-

infiniband-diags – диагностические утилиты OpenFabrics Alliance InfiniBand

Инструменты встроенного ПО Mellanox

Пакет Mellanox Firmware Tools (MFT) является набором инструментария управления встроенным ПО для отдельного узла InfiniBand. MFT может применяться для:

-

Создания стандартного или настроенного под пользователя образа встроенного ПО Mellanox

-

Записи образа встроенного ПО на отдельном узле InfiniBand

MFT содержит следующие инструменты:

-

mlxburn – предоставляет такую функциональность:

-

Создания стандартного или настроенного под пользователя образа встроенного ПО Mellanox для его записи - в формате .bin или .img

-

Записи образа в Flash/EEPROM подключённого Mellanox HCA или устройства коммутации

-

Запроса версии встроенного ПО, загруженного на плату HCA

-

Отображение VPD (Vital Product Data) платы HCA

-

-

flint

Данный инструмент записывает двоичный образ или расширение образа ROM в Flash устройства сетевого адаптера/ моста/ коммутатора Mellanox. Он содержит функции запроса прописанного образа встроенного ПО и к файлу двоичного образа.

-

Утилиты отладки

Набор утилит отладки (т.е. itrace, fwtrace, mlxtrace, mlxdump, mstdump, mlxmcg, wqdump, mcra, mlxi2c, i2c, mget_temp, and pckt_drop)

За дополнительными подробностями, пожалуйста, обращайтесь к руководству пользователя MFT в docs/.

См. источник, Mellanox OFED for Linux User Manual

См. источник, Mellanox OFED for Linux User Manual

Обычно приложениям необходимо создать очередь к возможностям устройства пред тем как оно попытается создать некий ресурс. Для приложений естественно иметь возможность работать с различными устройствами обладающими различными возможностями

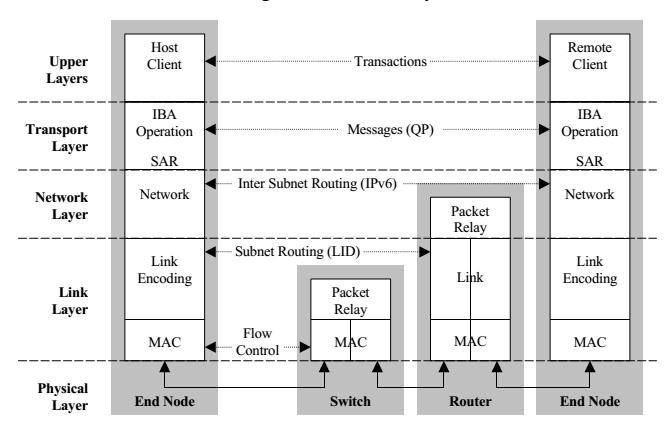

В особенности, при создании QP пользователям необходимо определить максимальное число необработанных рабочих запросов, поддерживаемых QP {Прим. пер.: QP, читай: пар очередей: -цитата из osp.ru- "В основе архитектуры IB лежит способность создавать очереди команд, которые выполняются IB-устройствами. Рабочие очереди всегда создаются парами (queue pair, QP): одна — для операций посылки, другая — для операций получения. Пары идентифицируются номером.", также см. Архитектура Infiniband и OFED того же источника. Иллюстрация для наглядности:}

Данное значение не должно превышать возможности обслуживания очередей. Однако, даже если вы определяете вы определяете значение, которое не превышает возможности, операций (verbs) могут всё ещё отвергаться, так как тербуются некоторые другие факторы наподобие записей рассеивания/ накопления (scatter/gather) или необходимого в реальном масштабе размера данных влияют на максимальное значение возможных запросов. Следовательно приложение должно попытаться уменьшить этот размер (хорошим новым значением будет уменьшение в два раза) и повторять попытку до достижения результата.

См. источник, Mellanox OFED for Linux User Manual

См. источник, Mellanox OFED for Linux User Manual

Поддержка RSS{~}

Поддержка операций RSS для HCA ConnectX®-4{~}

Технология Масштабирование на стороне приема (RSS, Receive Side Scaling) позволяет распределять приходящую сетевую нагрузку между различными принимающими очередями дескрипторов. Назначение каждой очереди различным ядрам ЦПУ улучшает балансировку входящей нагрузки и улучшает производительность.

Данная технология была расширена на пространство пользователя уровнем операций (verbs) и может применяться для RAW ETH QP.

См. источник, Mellanox OFED for Linux User Manual

Существует несколько протоколов, которые используют преимущества Infiniband и RDMA по причинам производительности (высокая пропускная способность, низкая латентность и небольшая загрузка ЦПУ). В данной главе мы обсудим следующие протоколы:

-

SCSI RDMA Protocol (SRP): разработан для получения всех преимуществ разгрузки протокола и функциональности RDMA предоставляемых архитектурой InfiniBand.

-

Sockets Direct Protocol (SDP): является транспортным протоколом потоков байт InfiniBand, предоставляющим семантику потоков TCP.

-

iSCSI Extensions for RDMA (iSER): является расширением модели передачи данных iSCSI, сетевого стандарта хранилищ для TCP/IP. Применяет компоненты iSCSI, при том что получает все преимущества комплекта протокола RDMA. ISER реализован на различных таргетах хранения, таких как TGT, LIO, SCST, но это выходит за пределы данного руководства.

Для этапов настройки, нахождения неисправностей и отладки различных таргетов ISER, а также прочих реализаций протоколов хранения поверх RDMA (например, NFS поверх RDMA, Ceph поверх RDMA, nbdx, и прочих) отсылаем к решениям хранения, сообщества Mellanox

-

Lustre: является параллельной распределённой файловой системой с открытым исходным кодом, обычно применяется для крупномасштабных вычислительных кластеров, которые поддерживают многие требования HPC сред моделирования ведущего уровня.

Для получения дополнительной информации обращайтесь, пожалуйста, к решениям хранения сообщества Mellanox (https://community.mellanox.com).

Протокол SCSI RDMA (SRP){~}

Протокол SCSI RDMA (SRP) разработан для получения полного преимущества разгрузки этого протокола и функциональности RDMA, предоставляемых архитектурой Infiniband. SRP позволяет большой массе программного обеспечения SCSI легко применяться в архитектуре InfiniBand. Инициатор SRP управляет соединением с таргетом SRP для предоставления доступа к удалённым устройствам хранения через среду коммутации InfiniBand. Таргет kSRP располагается на устройстве ввода-вывода и предоставляет службы хранения.

Инициатор SRP основан на открытом программном коде OpenFabrics (www.openfabrics.org), который реализует SCSI RDMA Protocol-2 (SRP-2). SRP-2 описан в документе # T10/1524-D, доступном по адресу http://www.t10.org.

Инициатор SRP поддерживает

-

Основные SCSI Primary Commands -3 (SPC-3) (www.t10.org/ftp/t10/drafts/spc3/spc3r21b.pdf).

-

Основные SCSI Block Commands -2 (SBC-2) (www.t10.org/ftp/t10/drafts/sbc2/sbc2r16.pdf).

-

Основную функциональность, управление задачами и ограниченную обработку ошибок.

Дальнейшие подробности, см. источник, Mellanox OFED for Linux User Manual

Sockets Direct Protocol (SDP){~}

Дальнейшие подробности, см. источник, Mellanox OFED for Linux User Manual

iSCSI Extensions for RDMA (iSER){~}

iSCSI Extensions for RDMA (iSER) распространяет протокол iSCSI на RDMA. Он делает возможной передачу данных непосредственно в буферы SCSI и из них без промежуточного копирования данных.

iSER применяет комплект протокола RDMA для поддержки наивысшей пропускной способности для обмена данных блочных хранилищ (режим работы с нулевым временем копирования). Для этого обстоятельства он прекращает обработку накладных расходов TCP/IP при сохранении полной совместимости с протоколом SCSI.

Существует три реализации таргета ISER:

-

Linux SCSI target framework (tgt)

-

Linux-IO target (LIO)

-

Generic SCSI target subsystem for Linux (SCST)

Каждый из этих таргетов может работать в транспортном режиме TCP или iSER.

iSER также поддерживает RoCE без каких либо дополнительных требований настройки. Для скрепления (bond) с интерфейсами RoCE установите

параметр fail_over_mac в связываемом драйвере (см. раздел Section 3.2.5.1.5,

"Bonding IPoIB" в Mellanox OFED for Linux User Manual)

RDMA/RoCE размещается ниже блока iSER в стеке сетевой среды. Для выполнения iSER уровень RDMA должен быть настроен и подтверждён (без разницы: поверх Ethernet или InfiniBand). Для поиска неисправностей RDMA, пожалуйста, обращайтесь к "HowTo Enable, Verify and Troubleshoot RDMA" в сообществе Mellanox.

Lustre{-}

См. источник, Mellanox OFED for Linux User Manual

Single Root IO Virtualization (SR-IOV){~}

Single Root IO Virtualization (SR-IOV) является технологией, которая позволяет физическим устройствам PCIe представлять себя многократно через шину PCIe. Данная технология делает возможными множество экземпляров одного устройства с различными ресурсами. Адаптеры Mellanox способны выставлять в платах адаптеров ConnectX®-3 до 126 виртуальных экземпляров, называемых виртуальными функциями (VF, Virtual Functions), а платы адаптеров ConnectX®-4/ConnectX-IB до 62 виртуальных экземпляров. Эти виртуальные функции далее могут предоставляться раздельно. Каждая VF может рассматриваться как дополнительное устройство, подсоединённое к физической функции (PF, Physical Function). Они совместно используют одни и те же ресурсы в физической функции, а их общее число портов равно числу портов физической функции.

SR-IOV обычно используется совместно совместно с разрешающим SR-IOV гипервизором для предоставления виртуальным машинам прямого доступа к сетевым ресурсам, тем самым увеличивая их производительность.

В данном разделе мы продемонстрируем сборку и настройку SR-IOV в среде Red Hat с применением семейства плат адаптеров ConnectX® VPI.

Системные требования

Для установки окружения SR-IOV необходимы:

-

Драйвер MLNX_OFED

-

Сервер/ блейд с BIOS материнской платы, поддерживающим SR-IOV

-

Гипервизор, который поддерживает SR-IOV, например: Red Hat Enterprise Linux Server Version 6.*

-

Плату адаптера семейства Mellanox ConnectX® VPI с возможностью SR-IOV

Сборка SR-IOV{-}

Дополнительная настройка SR-IOV{-}

Деинсталяция SR-IOV{-}

Подробности, см. источник, Mellanox OFED for Linux User Manual

Разрешение паравиртуализации{-}

См. источник, Mellanox OFED for Linux User Manual

Разгрузка оборудования VXLAN без запоминания состояния{~}

Технология VXLAN предоставляет бросающие вызов решения масштабируемости и безопасности. Она требует расширений для обычных разгружающих процедур без запоминания состояния для исключения падения производительности. Семейства адаптеров ConnectX®-3 Pro и ConnectX®-4 предлагают приводимые ниже процедуры разгрузки без запоминания состояния для пакетов VXLAN, аналогичные процедурам, предлагаемым для не инкапсулируемых пакетов. Протокол VXLAN инкапсулирует свои пакеты используя внешний заголовок UDP.

Доступные аппаратные процедуры разгрузки без запоминания состояния:

-

Генерация контрольной суммы (Inner IP и Inner TCP/UDP)

-

Подтверждение контрольной суммы (Inner IP и Inner TCP/UDP). Это позволит применять GRO (только для плат ConnectX®-3 Pro) для содержимого пакетов TCP

-

Разгрузка сегментации TCP (TSO, TCP Segmentation Offload) для содержимого пакетов TCP

-

Масштабирование на стороне приема (RSS, Receive Side Scaling) в соответствии с внутренними атрибутами пакетов

-

Выбор принимающей очереди - внутренние кадры могут направляться в специфические QP ( пары очередей)

Для аппаратных процедур разгрузки VXLAN без запоминания состояния необходимо выполнение следующих предварительных требований:

-

HCA и их минимальное встроенное ПО требуют:

-

ConnectX-3 Pro - Firmware v2.32.5100

-

ConnectX-4 - Firmware v12.14.xxxx

-

ConnectX-4 Lx - Firmware v14.14.xxxx

-

-

Операционная система:

-

RHEL7, Ubuntu 14.04 или восходящее ядро 3.12.10 (или выше)

-

-

Функции, поддерживаемые upstream kernel:

-

DMFS enabled

-

A0 static mode disabled

-

Разрешение разгрузки оборудования VXLAN без запоминания состояния для ConnectX®-3 и ConnectX®-3 Pro{-}

Разрешение разгрузки оборудования VXLAN без запоминания состояния для семейства устройств ConnectX®-4{-}

Важные замечания{-}

См. источник, Mellanox OFED for Linux User Manual

Reset Flow{~}

Поток сброса (Reset Flow) активируется по умолчанию при обнаружении ошибки "fatal device" (а именно: это может быть

таймаут по команде втроенного ПО, ошибка закрытия команды встроенного ПО, отсутствие ответа коммуникационного канала в виртуальном интерфейсе -VF,

а также тому подобное). И HCA, и программное обеспечение выполняют сброс, а ULP и приложения пользователя получают об этом уведомления, после

чего выполняется процесс восстановления. "Reset Flow" активируется параметром модуля mlx4_core

'internal_err_reset' и его значение по умолчанию установлено в 1.

ULP ядра{-}

Приложения пространства пользователя (IB/RoCE){-}

SR-IOV{-}

Принудительный сброс виртуального интерфейса (VF){-}

Усовершенствованные сообщения об ошибках (AER) для ConnectX®-3 и ConnectX®-3 Pro{-}

Расширенная обработка ошибок (EEH){-}

См. источник, Mellanox OFED for Linux User Manual

Для получения информации отсылаем вас к руководству пользователя HPC-X® www.mellanox.com > Products > Software > HPC-X > HPC-X toolkit

См. источник, Mellanox OFED for Linux User Manual

См. источник, Mellanox OFED for Linux User Manual

![[Замечание]](/common/images/admon/note.png)